日處理20億數據 實時用戶行為服務系統架構實踐

隨著互聯網業務的快速發展,用戶行為數據已成為驅動產品優化、精準營銷和智能決策的核心資產。面對每日高達20億條數據的處理需求,構建一個高可用、低延遲、可擴展的實時用戶行為服務系統至關重要。本文將深入探討支撐如此龐大數據量的系統架構設計、關鍵組件選型及實踐挑戰。

一、 系統核心目標與挑戰

在日處理20億數據的規模下,系統設計需滿足以下核心目標:

1. 高吞吐與低延遲:數據產生后需在秒級甚至毫秒級內完成采集、處理與可查詢。

2. 高可用與容錯:系統需保證7x24小時穩定運行,任何單點故障不應影響整體服務。

3. 水平可擴展:架構需能通過增加節點平滑應對數據量的持續增長。

4. 數據一致性:在分布式環境下,需在最終一致性與查詢實時性之間取得平衡。

主要挑戰包括海量數據的快速攝入、實時計算資源調度、存儲成本控制以及復雜查詢的響應效率。

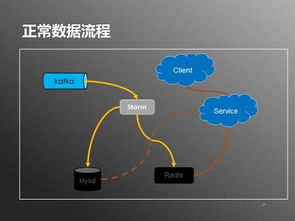

二、 整體架構設計

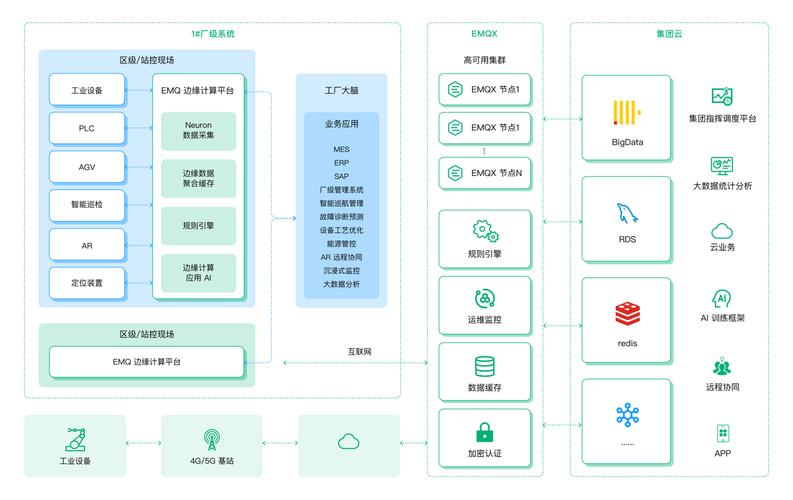

一個典型的實時用戶行為數據處理服務系統通常采用分層架構,自下而上分為數據采集層、消息緩沖層、實時計算層、存儲服務層和應用接口層。

1. 數據采集層

輕量級SDK:在客戶端(Web/App/小程序)嵌入輕量級SDK,負責收集頁面瀏覽、點擊、啟動等事件,進行初步格式化與壓縮。

網關集群:SDK將數據發送至高可用的網關集群(如Nginx + OpenResty),網關負責負載均衡、初步驗簽、限流及將數據異步推送至下游消息隊列。此層需具備極強的橫向擴展能力。

2. 消息緩沖層

* 分布式消息隊列:選用高吞吐、支持持久化的消息中間件,如Apache Kafka或Pulsar。該層作為系統的“主動脈”,解耦采集與處理,應對流量峰值,并保證數據不丟失。針對20億/天的數據量,需對Kafka集群進行合理的Topic分區規劃與副本配置。

3. 實時計算層

流處理引擎:這是系統的“大腦”。采用Apache Flink作為核心流處理框架,其精確一次(Exactly-Once)語義、高吞吐和低延遲特性非常適合實時用戶行為分析。

計算任務:Flink作業從Kafka消費數據,進行一系列處理:

* 數據清洗與格式化:過濾無效數據,統一字段格式。

- 實時統計:進行窗口聚合計算(如每分鐘活躍用戶數、事件計數)。

- 規則匹配與觸發:對接預設規則(如用戶完成特定路徑后發券),實時輸出觸發事件。

- 多維關聯:將行為事件與用戶畫像、物料信息等進行實時關聯,豐富數據維度。

- 該層通常以YARN或Kubernetes作為資源調度平臺,實現計算任務的彈性擴縮容。

4. 存儲服務層

實時存儲:處理后的實時結果(如聚合指標、觸發事件)需要被快速寫入和查詢。可選用:

OLAP數據庫:如ClickHouse或Doris,用于支持高速、多維的即時查詢(Ad-hoc Query)。

- 寬表數據庫:如HBase/Cassandra,以KV或寬表形式存儲明細或用戶粒度聚合數據,支持快速點查。

- 時序數據庫:如InfluxDB,專門存儲時間序列化的指標數據。

- 冷備份與離線分析:原始數據及歷史明細可定期歸檔至HDFS或對象存儲(如S3/OSS),供離線數據倉庫(如Hive)進行深度挖掘與批量報表生成。

5. 應用接口層

對外提供統一的RESTful API或GraphQL接口,供業務系統(如運營平臺、推薦系統、風控系統)查詢實時用戶行為指標、標簽或接收實時事件推送。

通常需要聚合查詢網關,根據查詢條件路由至不同的底層存儲引擎。

三、 關鍵實踐與優化

- 數據分片與壓縮:在Kafka、Flink State及存儲系統中,合理設計分區鍵(如

user_id),使數據均勻分布。采用高效的壓縮算法(如Snappy、LZ4)減少網絡與存儲IO。 - 資源動態調度:基于Kafka Lag監控和系統負載,自動伸縮Flink任務并行度及計算資源,在成本與性能間取得平衡。

- 多級緩存:在查詢網關和API層引入Redis等緩存,存儲熱點查詢結果,大幅降低對底層存儲的壓力,提升查詢響應速度。

- 監控與告警體系:建立全方位的監控,涵蓋從數據采集延遲、Flink Checkpoint時長、Kafka堆積量到各存儲節點負載、API響應時間等關鍵指標,并設置智能告警。

- 數據治理與質量:定義清晰的數據規范,在流處理環節進行嚴格的數據質量校驗(如非空、枚舉值、關聯存在性),并建立數據血緣追蹤,確保數據的可信度。

四、

構建日處理20億數據的實時用戶行為服務系統是一項復雜的系統工程,其核心在于一個流式驅動的、各層解耦的、可水平擴展的架構。通過合理組合像Kafka、Flink、ClickHouse這樣經過大規模實踐驗證的組件,并輔以精細化的資源管理、數據治理和監控運維,能夠有效應對海量數據實時處理的挑戰,將數據流轉化為驅動業務增長的實時價值流。隨著流批一體技術和云原生數據基礎設施的成熟,此類系統的構建與運維將更加高效與智能。

如若轉載,請注明出處:http://www.acpacwd.cn/product/50.html

更新時間:2026-01-21 01:49:52